Din Content Marketing står inför en större förändring än vad du har upplevt de senaste året, kanske någonsin och tack vare Google’s lansering av BERT häromdagen.

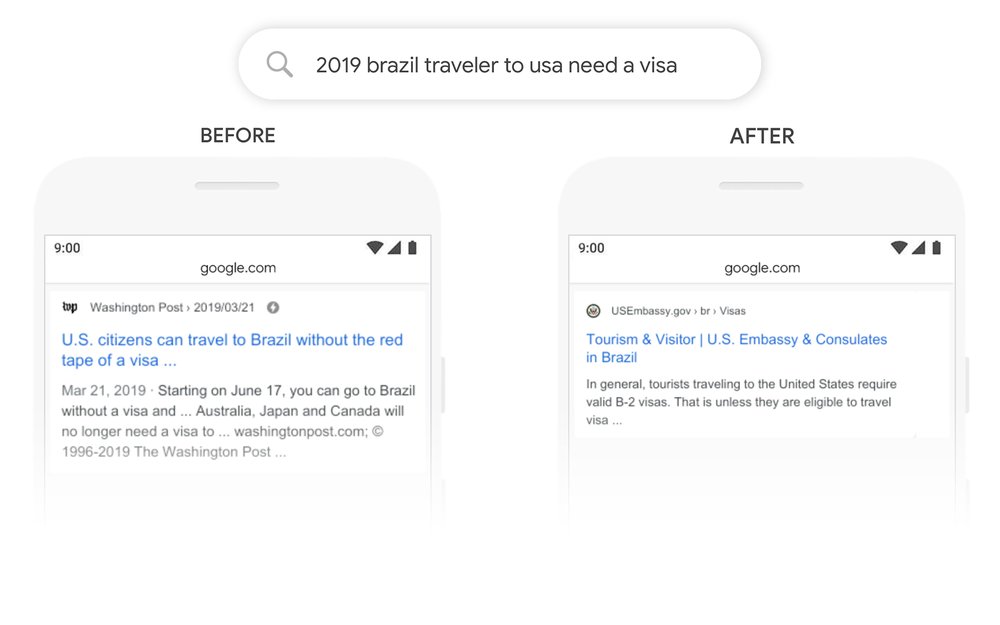

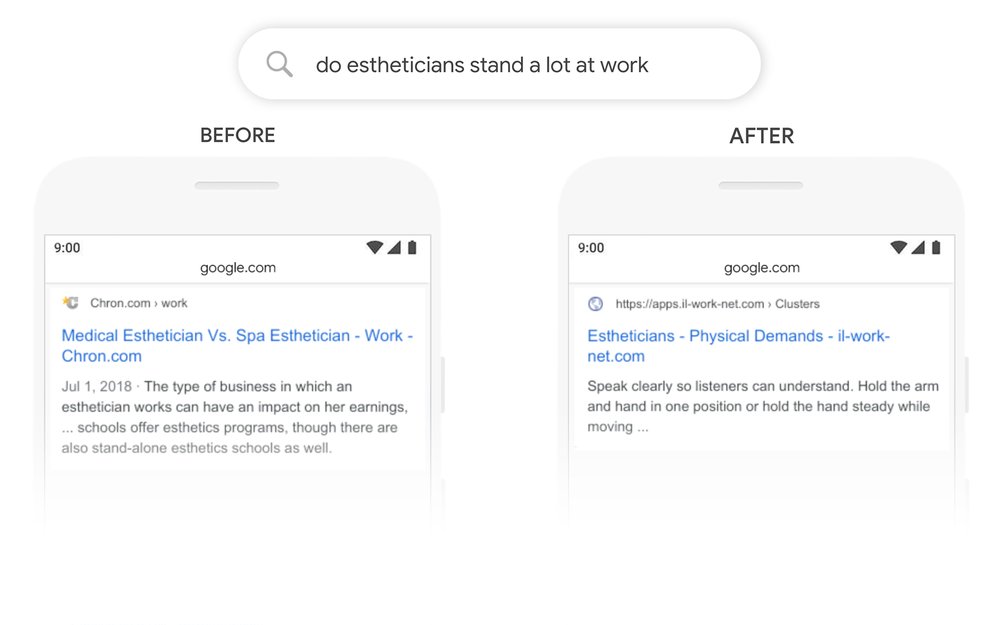

Google säger öppet att BERT förbättrar sökresultatet och du kan se Google’s exempel längre ned.

Eftersom Google är den största källan till besökare för våra webbplatser (källa: Jumpshot, 2019) med hela 57%, facebook kommer på en andra plats med ca 5%, så är det viktigt att förstå hur Google fungerar.

Vad är BERT?

BERT handlar språkteknologi som analyserar våra texter på djupet, exempelvis prepositioner och Google vill helt enkelt förstå vad vi menar med våra texter och framförallt när det finns ord som är dubbelriktade dvs samma ord som kan betyda olika saker beroende på hur det används.

Tack vare detta finns det framöver ännu godare chanser att få ökad synlighet även om du inte har stenkoll på hur du ska sökmotoroptimera dina texter och missar att nämna alla relevanta ord i din text som ofta används när din målgrupp söker på Google.

BERT har testats rigoröst och har nu lanserats på engelska språket men fler kommer i framtiden.

Så påverkar BERT din Content Marketing

Redan idag finns möjligheten för dina texter att bli synliga vid sökningar på Google på sökfraser som du inte har nämnt i dina texter texter tack vare Google’s lansering av Rankbrain i November 2015 (Artificiell Intelligens i Google’s algoritm).

10% kommer att påverkas av BERT säger Google och efter att jag har gjort en hel del research i Google’s dokument så verkar det främst röra sig om sökningar med frågeställningar även när dessa frågor inte är tydligt framkommer i texten utan är mer indirekta frågor.

Idag är det vanligt att man använder en eller ett fåtal huvudsökfraser för en text, det är dessa sökfraser som man vill att texten ska bli synlig för sökande på Google. Därefter använder man relaterade ord och fraser i sina texter som förtydligar för Google vad din text handlar om, vilket ämne och vilka frågor som du besvarar.

Med BERT så kommer du troligen att kunna svara på många fler frågor utan att ha kolla på alla sökvarianter som ställs på Google.

Varför lanserar Google BERT?

BERT, som står för ‘Bidirectional Encoder Representations from Transformers’, lanserades nyligen som en del i Google’s analyser och utvärdering av webbplatsers texter som Google har ‘spindlat’ och vill presentera i sina sökresultat.

Med BERT så kan Google presentera fler alternativ på svar för de som söker men som inte riktigt vet hur de ska skriva sina texter för att Google ska förstå, dvs de som inte förstår sökmotoroptimering. Med BERT så ökar Google kvalitén i sökresultaten och det är precis vad deras tester har påvisat.

Mjukvaran BERT är inte helt nytt, Google har under en längre tid låtit den genomgå rigorösa tester har låtit delar av mjukvaran varit öppen som ‘open source’ så att externa personer har kunnat bidra med träning och utvärdering för kvalitetssäkring.

BERT processar språk som ofta definieras som NLP (Natural Language Processing) och är egentligen inget nytt utan det har funnits i många år.